機械学習の概要とプロセス

機械学習とは、データを使ってコンピュータが自ら学習し、予測や分類を行う技術です。

この章では、まず機械学習とは何かについて基本的な概念を説明します。次に、機械学習が人工知能(AI)の一分野であり、どのようにデータを使ってコンピュータが自ら学習し、予測や分類を行う技術であるかを理解します。また、ディープラーニングの位置付けについても触れます。その後、機械学習のプロセス全体の流れを紹介し、各ステップがどのような役割を果たしているかを概観します。

機械学習とは何か

人工知能(Artificial Intelligence)とは、「人工的につくられた人間のような知能、ないしはそれをつくる技術」を指します。AIは、人間のように学習し、推論し、意思決定を行う能力を持つシステムです。AIの定義はさまざまですが、共通しているのは、人間の知的な活動を模倣することを目指している点です。

AIの内部には、いくつかの階層があります。その中でも重要な概念が「機械学習(Machine Learning)」と「ディープラーニング(Deep Learning)」です。

機械学習は、AIの一分野であり、データを用いてモデルをトレーニングし、そのモデルが新しいデータに対して予測や分類を行う技術です。機械学習は、人間がルールを明示的にプログラムしなくても、データからパターンを見つけ出すことができます。

ディープラーニングは、機械学習の一種であり、特に多層のニューラルネットワークを使用する手法です。ディープラーニングは、画像認識や自然言語処理などの高度なタスクにおいて高い性能を発揮します。

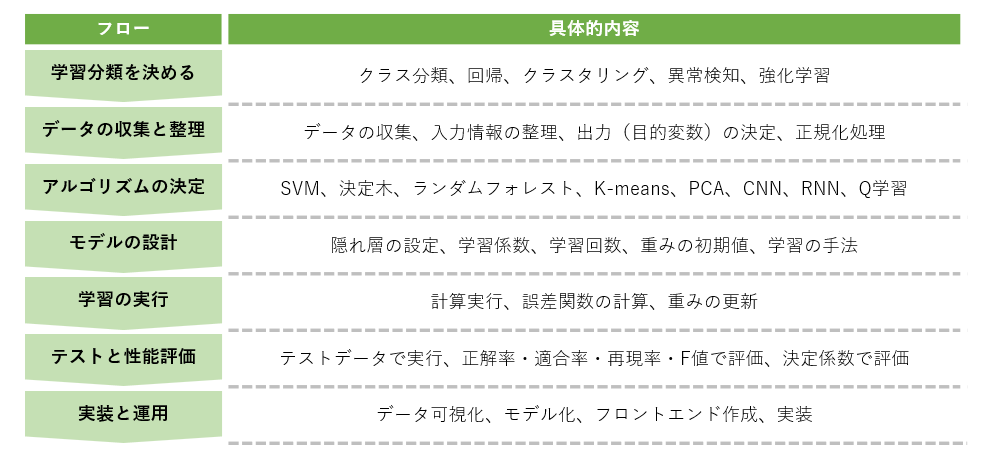

機械学習のプロセス

機械学習プロジェクトは以下のステップで構成されており、それぞれのステップが重要な役割を果たしています。ここでは、各ステップの意味や目的を説明します。

- 学習分類を決める: 機械学習プロジェクトの第一歩は、プロジェクトの目的に応じて、どのタイプの学習を行うかを決定することです。これは、機械学習モデルが解決するべき問題の種類を特定するプロセスです。例えば、スパムメールのフィルタリングを行いたい場合は、クラス分類を選択します。このステップでは、プロジェクトの目標を明確にし、それに最適な学習方法を選ぶことが重要です。

- データの収集と整理: 次に、モデルのトレーニングに必要なデータを集め、それを整理します。データは機械学習の基盤であり、モデルの性能に大きな影響を与えます。このステップでは、信頼性の高いデータソースからデータを収集し、データの質を向上させるために前処理を行います。前処理には、異常値の除去やデータの標準化などが含まれます。データの整理がしっかり行われていれば、後のプロセスがスムーズに進みます。

- アルゴリズムの決定: データが整ったら、次に使用するアルゴリズムを選びます。アルゴリズムは、データを処理してパターンを見つけ出し、予測や分類を行うための手法です。プロジェクトの目標やデータの特性に応じて、最適なアルゴリズムを選定することが成功の鍵です。正しいアルゴリズムを選ぶことで、モデルの性能を最大限に引き出すことができます。

- モデルの設計: 選定したアルゴリズムに基づいて、具体的なモデルを設計します。モデル設計では、ニューラルネットワークの層数やノード数、学習率などのパラメータを設定します。これらのパラメータは、モデルの複雑さや学習の効率に影響を与えます。適切なモデル設計は、高精度な予測や分類を実現するために不可欠です。

- 学習の実行: 設計したモデルを実際に学習させます。このステップでは、データを用いてモデルをトレーニングし、パターンを学習します。学習プロセス中に、モデルはデータから経験を積み、予測精度を向上させます。適切な学習手法を用いることで、モデルがデータの特徴を正確に捉えることができます。

- テストと性能評価: 学習が完了したモデルをテストデータで評価します。テストデータは、モデルが実際にどれだけ正確に予測や分類を行えるかを測定するためのものです。評価指標として、正解率や適合率、再現率、F値などが使用されます。このステップでの評価結果に基づき、モデルの改善点を特定し、必要に応じて調整を行います。

- 実装と運用: 最終ステップでは、学習と評価が完了したモデルを実際の環境で運用します。モデルの実装には、予測結果を可視化するためのグラフやチャートの作成、ユーザーがモデルの出力を利用できるようにするためのフロントエンドの開発などが含まれます。これにより、モデルが実際のビジネスやサービスで活用され、価値を生み出すことができます。

以上が機械学習の基本的なプロセスです。各ステップを丁寧に行うことで、精度の高い機械学習モデルを構築することができます。

学習分類を決める

プロジェクトの目的やデータの特性に基づいて適切な学習分類を選びましょう。

機械学習プロジェクトの第一歩は、プロジェクトの目的に応じて、どのタイプの学習を行うかを決定することです。適切な学習分類を選ぶことで、プロジェクトの目標を効率的に達成できます。

学習分類の種類

機械学習には、データの特性やプロジェクトの目的に応じて様々な学習分類の手法があります。これらの手法は、データをどのように分類し、予測するかに基づいて選ばれます。

| 学習分類 | 説明 | 具体例 |

|---|---|---|

| クラス分類 | データを事前に定義されたクラスに分類する手法 | スパムフィルタリング、手書き文字認識、顧客の購買傾向分類 |

| 回帰 | 連続する数値を予測する手法 | 不動産価格予測、売上予測、気温予測 |

| クラスタリング | データを似た特徴に基づいてグループ分けする手法 | 顧客セグメンテーション、ニュース記事分類、マーケットバスケット分析 |

| 異常検知 | 通常のパターンから逸脱した異常なデータを検出する手法 | 不正取引検出、機器の故障予知、ネットワーク侵入検知 |

| 強化学習 | エージェントが環境との相互作用を通じて最適な行動を学習する手法 | ゲームAI、ロボット制御、自動運転 |

- クラス分類: クラス分類は、データを事前に定義されたクラスに分類するタスクです。例えば、スパムメールのフィルタリングでは、メールが「スパム」か「スパムでない」かを分類します。他の例としては、手書き文字の認識や、顧客の購買傾向の分類などがあります。

- 回帰: 回帰は、連続する数値を予測するタスクです。例えば、不動産の価格予測や売上の予測などが含まれます。回帰モデルは、入力データと出力データの間の関係を学習し、新しいデータに基づいて連続的な値を予測します。

- クラスタリング: クラスタリングは、データを似た特徴に基づいてグループ分けするタスクです。例えば、顧客のセグメンテーションや、ニュース記事のトピック分類などがあります。クラスタリングは、ラベルのないデータを分類するための手法として用いられます。

- 異常検知: 異常検知は、通常のパターンから逸脱した異常なデータを検出するタスクです。例えば、不正取引の検出や、機器の故障予知などが含まれます。異常検知は、正常なデータと異常なデータを区別するための手法です。

- 強化学習: 強化学習は、エージェントが環境との相互作用を通じて最適な行動を学習するタスクです。例えば、ゲームAIやロボット制御などがあります。強化学習は、エージェントが報酬を最大化するように行動を調整するための手法です。

学習分類の選定

学習分類の選定は、プロジェクトの成功に直結します。プロジェクトの目的やデータの特性に基づいて適切な分類を選びましょう。以下のポイントを考慮すると良いでしょう。

- 目的の明確化: プロジェクトの最終的な目標を明確にします。予測したいのか、分類したいのか、データのパターンを見つけたいのかを決めることが重要です。

- データの特性: 使用するデータの特性を理解します。データが連続的な値を持つのか、カテゴリデータなのか、ラベルがあるのかないのかを確認しましょう。

- 利用シナリオ: モデルを実際にどのように利用するかを考慮します。リアルタイムでの予測が必要なのか、バッチ処理での分析が適しているのかなどを検討します。

- アルゴリズムの適合性: 各分類アルゴリズムの特性を理解し、データと目的に最も適したアルゴリズムを選びます。例えば、線形分離が可能な場合にはロジスティック回帰や線形判別分析が有効であり、複雑な非線形関係が存在する場合には決定木やニューラルネットワークが適しています。

- パフォーマンスと計算コスト: モデルの精度だけでなく、トレーニングと予測にかかる計算コストも考慮します。高精度のモデルでも計算コストが高ければ実運用に適さない場合があります。

データの収集と整理

データは機械学習の基盤であり、モデルの性能に大きな影響を与えます。

機械学習プロジェクトにおいて、データは非常に重要な要素です。データの質が高ければ高いほど、モデルの性能も向上します。データの収集方法と整理方法について詳しく解説します。

データ収集の手法

データ収集は、機械学習プロジェクトの基盤であり、モデルの性能に直接影響します。

- インターネットからのデータ収集: ウェブスクレイピングは、インターネット上の公開データを自動的に収集する手法です。例えば、ニュースサイトから記事を収集したり、SNSから投稿を取得する際に使われます。API利用は、ウェブサービスが提供するAPIを使ってデータを取得します。例えば、Twitter APIを使ってツイートデータを収集するなどが一般的です。

- 企業内部のデータベース: 企業が保有する内部データベースから必要なデータを抽出して利用します。例えば、顧客情報、販売データ、在庫情報などが該当します。これらのデータは、企業の運営に関する具体的な情報を提供し、顧客の行動パターンや市場のトレンドを分析するのに役立ちます。

- 公開データセット: 政府機関や研究機関が公開しているデータセットを利用します。例えば、UCI Machine Learning RepositoryやKaggleからデータをダウンロードして使用することができます。これらのデータセットは、研究や教育目的で広く利用されており、機械学習モデルのトレーニングや評価に役立ちます。

データ整理の手法

データ整理は、収集したデータを分析やモデルのトレーニングに適した形式にするための重要なステップです。

- データクリーニング: 異常値や欠損値を検出して除去し、データをクリーンな状態にします。例えば、センサーの故障により異常な値が記録される場合、それらを除去します。欠損値の補完には、平均値や中央値を使った方法があります。

- データの正規化: 各特徴量のスケールを統一するために、Min-Maxスケーリングや標準化を使用します。これにより、異なるスケールの特徴量が同等に扱われ、モデルの学習が安定しやすくなります。

- カテゴリカルデータのエンコーディング: カテゴリカルデータ(例:性別、職業など)を数値データに変換します。One-Hotエンコーディングやラベルエンコーディングが一般的な手法です。

- 特徴量エンジニアリング: モデルの性能を向上させるために、新しい特徴量を作成します。例えば、日付データから曜日や月を抽出する、複数の特徴量を組み合わせて新しい特徴量を作成するなどの方法があります。

アルゴリズムの決定

数あるアルゴリズムから適切なモデルを選びます。

データの特性やプロジェクトの目的に適したアルゴリズムの選定をします。代表的な機械学習アルゴリズムの種類と、それぞれの特徴について解説します。

主な機械学習アルゴリズム

様々な機械学習アルゴリズムが存在します。学習分類やデータの特性に応じて、適切な手法を選ぶ必要があります。

| アルゴリズム | 説明 |

|---|---|

| サポートベクターマシン(SVM) | 高次元空間でデータを分類するアルゴリズム。非線形なデータにも対応できるが、計算コストが高い。 |

| 決定木 | データを木の構造に分割し、予測や分類を行うシンプルなアルゴリズム。解釈性が高いが、過学習しやすい。 |

| ランダムフォレスト | 多数の決定木を組み合わせて予測を行うアンサンブル学習法。過学習を防ぎ、高い精度を実現する。 |

| k-means | データをk個のクラスタに分けるクラスタリングアルゴリズム。シンプルだが、初期値に依存することがある。 |

| PCA(主成分分析) | データの次元を削減し、重要な特徴を抽出する手法。データの可視化や前処理に有用。 |

| CNN(畳み込みニューラルネットワーク) | 画像データの処理に優れた深層学習アルゴリズム。特徴抽出と分類を同時に行う。 |

| RNN(リカレントニューラルネットワーク) | 時系列データの処理に適した深層学習アルゴリズム。シーケンスの情報を保持し、解析する。 |

| Q学習 | 強化学習の一種で、エージェントが環境から学習して最適な行動を選択する。 |

- サポートベクターマシン(SVM): 高次元空間でデータを分類し、非線形なデータにも対応可能です。分類精度が高い一方で、計算コストが高くなることがあります。

- 決定木: データを条件に基づいて分割し、木の形で予測や分類を行います。視覚化が容易で解釈しやすいですが、過学習しやすいため適切な剪定が必要です。

- ランダムフォレスト: 複数の決定木を組み合わせることで過学習を防ぎ、安定した予測を提供します。特徴量の重要度を評価するのにも役立ちます。

- k-means: データをk個のクラスタに分けるクラスタリング手法です。シンプルで直感的ですが、初期値に依存しやすいです。

- PCA(主成分分析): データの次元を削減し、重要な特徴を抽出する手法です。データの可視化や前処理に有用で、解析の効率を上げます。

- CNN(畳み込みニューラルネットワーク): 画像データの処理に特化しており、特徴抽出と分類を同時に行います。ディープラーニングの一種であり、高い精度を誇ります。

- RNN(リカレントニューラルネットワーク): 時系列データやシーケンスデータの解析に優れており、過去の情報を保持しつつ新しいデータを処理する能力があります。

- Q学習: 強化学習の一種で、エージェントが環境から報酬を得ることで最適な行動を学習します。ロボティクスやゲームAIに広く利用されます。

アルゴリズムの選定基準

アルゴリズムを選定する際には、以下の基準を考慮します。

- 目的と目標: プロジェクトの具体的な目的や目標に応じてアルゴリズムを選びます。分類、回帰、クラスタリング、次元削減、強化学習など、解決したい問題に適したアルゴリズムを選定します。

- データの特性: データが線形分離可能か非線形かに応じて適したアルゴリズムが異なります。SVMは非線形データに強く、線形分離可能なデータにはロジスティック回帰が有効です。

- データのサイズと次元数: 大規模データセットには、計算コストの低いアルゴリズムが適しています。次元削減手法(例えばPCA)も考慮されます。

- 計算リソース: 利用可能な計算リソースに基づいてアルゴリズムを選定します。CNNやSVMは計算リソースを多く消費しますが、ナイーブベイズやk-meansは比較的軽量です。

- モデルの解釈性: 解釈性が重視される場合、決定木やランダムフォレストのようなシンプルなアルゴリズムが選ばれます。ビジネス上の意思決定や説明責任が必要な場合に重要です。

モデルの設計

アルゴリズムの細かい条件を設定をします。

選定したアルゴリズムに基づき、適切なモデルを設計することで、データからの学習が効果的に行われます。モデル設計の要素とその詳細について解説します。

ハイパーパラメータの設定

ハイパーパラメータは、モデルの学習プロセスにおける重要な設定項目です。適切なハイパーパラメータの設定により、モデルの性能を最大化することができます。主要なハイパーパラメータとその設定のポイントについて説明します。

サポートベクターマシン(SVM)

- 正則化パラメータ(C): このパラメータは、誤分類をどれだけ許容するかを決めます。大きな値に設定すると、モデルは誤分類を少なくするためにデータに厳密に適合しやすくなります。小さな値に設定すると、モデルは誤分類を許容し、より柔軟になります。適切な値を見つけるためには、異なる値を試してみる必要があります。

- カーネルタイプ: データをどのように変換して分類するかを決めます。一般的なカーネルには、RBF(ガウスカーネル)、ポリノミアルカーネル、線形カーネルがあります。各カーネルはデータの特性に応じて使い分けます。例えば、RBFカーネルは非線形のデータに適しており、線形カーネルはデータが直線で分けられる場合に使用します。

決定木

- 深さ(max_depth): 決定木の深さは、ツリーがどれだけ深く枝分かれするかを示します。深すぎるとツリーが複雑になりすぎて、訓練データに過剰に適合しやすくなります(過学習)。一方、浅すぎるとツリーが単純すぎて、データのパターンを十分に捉えられません(アンダーフィッティング)。適切な深さを見つけるためには、試行錯誤して調整する必要があります。

- 分割の最小サンプル数(min_samples_split): ノードをさらに分割するために必要な最小サンプル数です。小さな値に設定すると、ツリーがより多くの枝分かれをしますが、過学習のリスクが高まります。大きな値に設定すると、ツリーが簡素になりすぎる可能性があります。このパラメータは、ツリーの複雑さと過学習を制御するのに役立ちます。

k-means

- クラスタ数(k): クラスタ数は、データを分割するグループの数を指定します。適切なクラスタ数を選ぶためには、エルボー法やシルエット分析を使用して、最適なkを見つけることが一般的です。

- 初期クラスタ中心の選定方法: 初期クラスタ中心の選定は、クラスタリングの結果に大きな影響を与えます。k-means++アルゴリズムを使用すると、初期クラスタ中心を適切に選定しやすくなります。これにより、クラスタの収束が早くなり、安定した結果が得られます。

- 反復回数(max_iter): k-meansアルゴリズムの最大反復回数を指定します。反復回数が多いほど、クラスタリングの精度が向上する可能性がありますが、計算コストも増加します。一般的には、収束するまで反復を続ける設定にしますが、計算時間を制限するために適切な最大反復回数を設定します。

ディープラーニング

- 学習率: モデルの重みを更新する際のステップサイズ。高すぎると発散し、低すぎると収束が遅くなります。適切な学習率を見つけるために、初期値を大きくして徐々に減少させる方法(Learning Rate Decay)や、Adamなどの最適化アルゴリズムを使うのが一般的です。

- バッチサイズ: 一度に処理するデータの数です。大きなバッチサイズは計算効率が良いですが、多くのメモリを消費します。小さなバッチサイズは計算効率が悪いですが、詳細な学習が可能です。一般的には32、64、128などの値が使われます。

- エポック数: 全データセットを何回学習するかを決めます。多すぎると過学習のリスクがあるため、早期停止(Early Stopping)を使って、学習が改善しなくなった時点で自動的に停止することが効果的です。

- 隠れ層の数とサイズ: 隠れ層は、ニューラルネットワークの学習能力を決定します。多くの隠れ層や大きな隠れ層は、複雑なパターンを学習するのに役立ちますが、過学習のリスクも高まります。最適な設定を見つけるために、グリッドサーチやランダムサーチを使ってパラメータを調整します。

ハイパーパラメータチューニングのポイント

ハイパーパラメータチューニングは、モデルの性能を最適化するために重要なプロセスです。以下に、ハイパーパラメータチューニングのポイントを紹介します。

- グリッドサーチ(Grid Search): 予め設定したハイパーパラメータの組み合わせをすべて試して最適な組み合わせを見つける方法です。計算コストが高くなることが多いですが、確実な結果が得られます。

- ランダムサーチ(Random Search): ハイパーパラメータの範囲を設定し、その範囲内でランダムに組み合わせを選んで最適なパラメータを見つける方法です。グリッドサーチよりも計算コストが低く、効率的に最適なハイパーパラメータを見つけられることが多いです。

- ベイズ最適化(Bayesian Optimization): ベイズ定理を用いて、ハイパーパラメータの選定を行う手法です。効率的に最適なハイパーパラメータを見つけることができます。

- 学習曲線のプロット: 学習曲線をプロットして、トレーニングデータと検証データの性能を視覚的に確認します。これにより、過学習や不足学習の兆候を早期に発見することができます。

学習の実行

学習は、ここまでの設定に応じてコンピュータが行います。

学習の実行は、機械学習モデルがデータを基にして予測や分類の能力を獲得するためのプロセスです。このステップでは、準備されたデータを用いてモデルをトレーニングします。Pythonのライブラリ(TensorFlowやPyTorch)を通じて、GPUの計算能力を利用することで、これらの複雑な計算が自動的に行われ、人の関与は最小限です。

学習時にモデル内部で行われる計算

学習の過程では、モデル内部でさまざまな計算が行われます。ここでは、サポートベクターマシン(SVM)、決定木、k-means、ディープラーニングにおける主要な計算プロセスについて説明します。

サポートベクターマシン(SVM)

- データの変換: カーネル関数を使用して、元のデータを高次元空間にマッピングします。これにより、非線形なデータも線形分離可能になります。

- 最適化問題の解決: マッピングされた高次元空間で、サポートベクターマシンはデータポイント間のマージンを最大化するための最適化問題を解きます。この際、ラグランジュ乗数法を使用して最適化します。

- モデルの更新: 最適化によって得られたサポートベクトルとそれに対応する重みを使用して、分類境界を定義します。

決定木

- データの分割: データを繰り返し二分することで、ツリー構造を作成します。各分割は、最も情報ゲインが大きい特徴量に基づいて行われます。

- 条件の評価: 各ノードで条件を評価し、データを左右の枝に分けます。最終的には、葉ノードで予測結果が決定されます。

- ツリーの構築: 全てのデータが分割されるか、事前に設定した停止条件に達するまで、このプロセスを繰り返します。

k-means

- 初期クラスタの選定: 初期のクラスタ中心(セントロイド)をランダムに選びます。

- クラスタ割り当て: 各データポイントを最も近いクラスタ中心に割り当てます。このステップは、ユークリッド距離を計算することで行われます。

- クラスタ中心の更新: 各クラスタ内のデータポイントの平均を計算し、新しいクラスタ中心を設定します。

- 反復処理: クラスタの割り当てとクラスタ中心の更新を、クラスタ中心が収束するまで繰り返します。

ディープラーニング

- フォワードパス: 入力データがモデルを通過し、各層で計算が行われます。ニューラルネットワークでは、各ニューロンが入力の加重和を計算し、活性化関数を適用して出力を生成します。

- 損失計算: モデルの出力と実際の値を比較し、損失(誤差)を計算します。代表的な損失関数には、平均二乗誤差(MSE)やクロスエントロピー損失があります。

- バックプロパゲーション: 損失を最小化するために、誤差を逆伝播させて各重みの勾配を計算します。これにより、各重みがどれだけ更新されるべきかが決定されます。

- 重みの更新: 計算された勾配を基に、重みを更新します。学習率を用いて重みの更新幅を調整します。代表的な最適化アルゴリズムには、確率的勾配降下法(SGD)やAdamがあります。

- 反復処理: 上記のプロセスをエポック数分繰り返し、モデルがデータからパターンを学習していきます。

テストと性能評価

トレーニングしたモデルの性能を評価し、必要に応じてモデルを改善します。

機械学習モデルのテストと性能評価は、モデルが実際のデータに対してどれだけ効果的に動作するかを確認するための重要なステップです。性能評価の方法と、評価指標について詳しく説明します。

テストによる性能評価

性能評価は、モデルがどれだけ正確に予測を行えるかを測定するプロセスです。以下の方法が一般的に用いられます。

- ホールドアウト検証: データセットをトレーニングデータとテストデータに分割し、トレーニングデータでモデルを学習し、テストデータで評価します。データの80%をトレーニングデータ、20%をテストデータとするのが一般的です。

- 交差検証(クロスバリデーション): データセットを複数のサブセットに分割し、各サブセットを使ってモデルを複数回評価します。K-fold交差検証が広く用いられ、これによりモデルの一般化性能を向上させることができます。

- ブートストラップ法(Bootstrap Method): データセットからサブセットをランダムにサンプリングし(サンプルを戻して再び選ぶことを許容する)、それらのサブセットを使って複数回のトレーニングと評価を行います。この方法は、データが少ない場合でもモデルの性能を安定して評価することができます。

モデルの評価指標

モデルの性能を定量的に評価するために、以下の評価指標が用いられます。

| 指標 | 説明 |

|---|---|

| 正解率(Accuracy) | 全体の予測のうち、正しく予測されたものの割合。分類問題でよく使用される。 |

| 適合率(Precision) | 正と予測されたもののうち、実際に正であったものの割合。 |

| 再現率(Recall) | 実際に正であったもののうち、正と予測されたものの割合。 |

| F1値(F1 Score) | 適合率と再現率の調和平均。バランスの取れた評価が可能。 |

| 平均二乗誤差(MSE) | 予測値と実際の値の差の二乗平均。回帰問題で使用される。 |

| 決定係数(R²スコア) | 回帰モデルの精度を示す指標。0から1の範囲で評価される。 |

モデル改善のアプローチ

評価結果に基づき、モデルの性能を改善するためのアプローチを検討します。

- 特徴量エンジニアリング: 新しい特徴量を作成し、モデルに提供するデータの質を向上させます。

- ハイパーパラメータチューニング: ハイパーパラメータを調整し、モデルの性能を最適化します。グリッドサーチやランダムサーチが一般的な方法です。

- 正則化の適用: モデルの複雑さを制御し、過学習を防ぐためにL1正則化やL2正則化を使用します。

- アンサンブル学習: 複数のモデルを組み合わせて予測を行うことで、性能を向上させます。バギング、ブースティング、スタッキングが代表的な方法です。

- データ増強: データの量を増やすことで、モデルの性能を向上させます。データの回転、平行移動、ズームイン・アウト、ノイズ追加などがあります。

- モデルの再学習: モデルが新しいデータを学習することで、性能を維持・向上させます。定期的にモデルを再学習させることで、最新のデータに基づいた予測が可能になります。

モデルの実装と運用

現実のビジネスやサービスで価値を生み出します。

トレーニングが完了した機械学習モデルを実際の環境で運用するためには、適切な実装と運用の手順を踏むことが重要です。

実装の手順

モデルを実運用するための基本的な手順を紹介します。

- モデルのエクスポート: トレーニング済みのモデルを適切な形式で保存します。一般的には、TensorFlowでは

.h5ファイル、PyTorchでは.ptファイルなどの形式が使われます。 - APIの作成: モデルをサービスとして提供するために、API(Application Programming Interface)を作成します。FlaskやFastAPIなどのフレームワークを使用して、モデルの予測機能をREST APIとして公開します。

- インフラストラクチャの設定: モデルをデプロイするためのインフラストラクチャを設定します。クラウドサービス(AWS、GCP、Azureなど)を利用して、スケーラブルな環境を構築します。Dockerを使ってコンテナ化し、Kubernetesでオーケストレーションすることも一般的です。

- セキュリティと認証: APIへのアクセスを制御し、セキュリティを確保するために、認証と認可のメカニズムを実装します。例えば、OAuthやJWTを使用してユーザー認証を行います。

- テストと検証: 実装したモデルとAPIが正しく動作することを確認するために、包括的なテストを行います。ユニットテスト、インテグレーションテスト、負荷テストなどを実施し、安定性と性能を確認します。

運用上のポイント

モデルの運用には、パフォーマンスの維持やシステムの安定性を確保するための様々なポイントがあります。

- モデルのモニタリング: 運用中のモデルのパフォーマンスを継続的に監視します。予測の精度や応答時間などのメトリクスをトラッキングし、異常が発生した場合にはアラートを設定します。

- 定期的な再トレーニング: モデルの性能が時間とともに低下する場合があります。新しいデータを取り入れて定期的にモデルを再トレーニングし、最新の状態を維持します。

- スケーラビリティの確保: ユーザー数やリクエスト数が増加しても対応できるように、システムのスケーラビリティを確保します。オートスケーリングを設定し、負荷に応じてリソースを動的に調整します。

- バージョン管理: モデルやAPIのバージョンを管理し、変更履歴を追跡します。これにより、過去のバージョンに戻すことが容易になります。

モデルの保守と監視

モデルの保守と監視は、運用中の問題は早期に発見し、迅速に対応するために重要です。

- ログ管理: モデルの動作に関するログを記録し、分析可能な状態に保ちます。これにより、問題のトラブルシューティングが迅速に行えます。

- エラーハンドリング: 運用中に発生するエラーを適切に処理し、システムの安定性を保ちます。エラーメッセージをログに記録し、必要に応じて通知を行います。

- データドリフトの検出: モデルが学習したデータと運用中のデータが異なる場合、データドリフトが発生します。定期的にデータドリフトを検出し、モデルの再トレーニングを行います。

まとめ

この記事では、機械学習の手順と実践について解説しました。

- 機械学習の概要とプロセス: 機械学習の基本概念と、AIの中での機械学習とディープラーニングの位置付けについて説明しました。また、機械学習プロジェクトの全体的なプロセスを概観しました。

- 学習分類の選定: 機械学習プロジェクトの目的に応じて適切な学習分類を選ぶ方法について解説しました。具体的な分類手法として、クラス分類、回帰、クラスタリング、異常検知、強化学習を紹介しました。

- データの収集と整理: データ収集の手法と、収集したデータをモデルのトレーニングに適した形式に整理する方法について説明しました。データクリーニング、正規化、カテゴリカルデータのエンコーディング、特徴量エンジニアリングなどの手法を解説しました。

- アルゴリズムの決定: データの特性やプロジェクトの目的に応じて適切なアルゴリズムを選定する基準を説明しました。代表的なアルゴリズムとして、サポートベクターマシン(SVM)、決定木、ランダムフォレスト、k-means、PCA、CNN、RNN、Q学習を紹介しました。

- モデルの設計: 選定したアルゴリズムに基づき、モデルの設計方法を説明しました。ハイパーパラメータの設定について、サポートベクターマシン、決定木、ニューラルネットワーク(ディープラーニング)に関して具体例を挙げて説明しました。

- 学習の実行: 準備されたデータを用いてモデルをトレーニングするプロセスについて説明しました。Pythonのライブラリ(TensorFlowやPyTorch)を通じて、GPUの計算能力を利用してトレーニングを自動化する方法を解説しました。

- テストと性能評価: レーニングしたモデルの性能を評価し、必要に応じてモデルを改善する方法について説明しました。評価指標として、正解率、適合率、再現率、F1値、平均二乗誤差、決定係数を紹介しました。

- モデルの実装と運用: レーニング済みのモデルを実際の環境で運用する方法と、そのための考慮点について解説しました。モデルのエクスポート、APIの作成、インフラストラクチャの設定、セキュリティと認証、テストと検証、運用上のポイント、モデルの保守と監視について説明しました。

この記事を通じて、機械学習プロジェクトの各ステップを理解し、実際にモデルを構築し運用するための基本的な知識を身につけることができたと思います。これを基に、具体的なプロジェクトに取り組む際の参考にしてください。

コメント